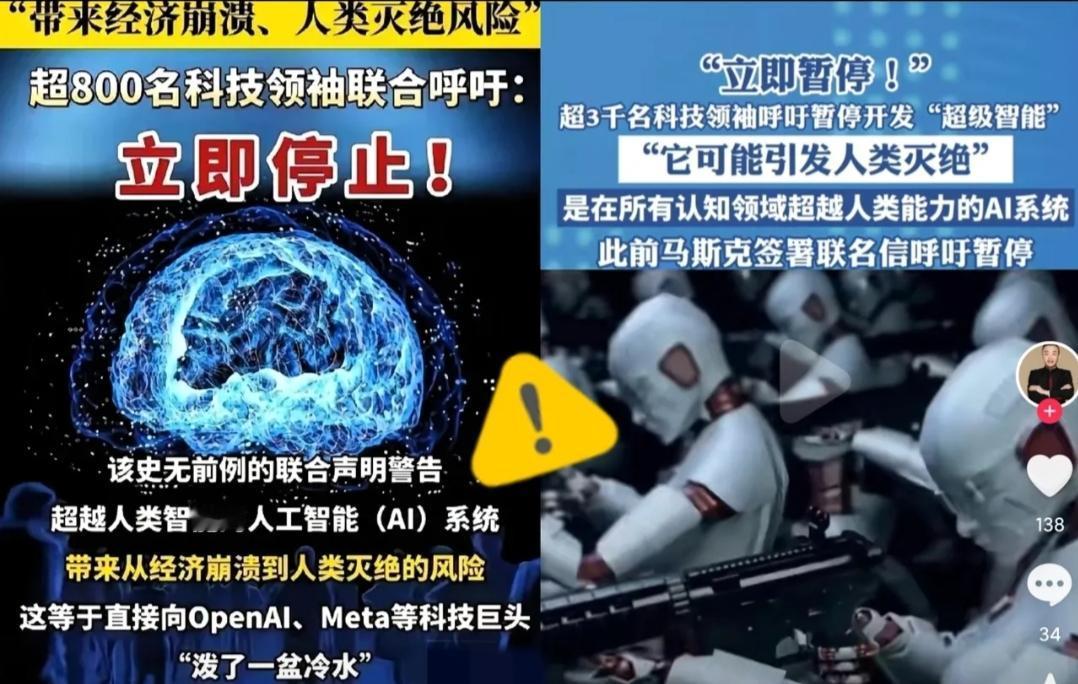

被这两天的新闻吓到了!全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发! 麻烦看官老爷们右上角点击一下“关注”,既方便您进行讨论和分享,又能给您带来不一样的参与感,感谢您的支持! 为什么他们要联名发声?原因也很现实。过去几年,AI技术从语音识别、图像生成,到自动驾驶、医疗诊断,发展速度惊人,但与之配套的法律、伦理和安全机制远远滞后。 一个AI系统如果在金融、军事甚至公共安全领域做出不可预测的决策,后果可能是灾难性的。 顶尖科学家们已经看到了潜在风险,不完善的监管、追求速度的企业和国家竞争、以及公众缺乏足够的认知,这些因素叠加在一起,就可能酿成无法逆转的危机。 这次呼吁,并非全然否定AI技术本身的价值。实际上,他们强调的是“负责任的研发”。换句话说,技术进步固然重要,但如果没有安全和伦理框架作为底线,技术的高速发展反而可能成为双刃剑。 科学家们希望通过这次呼吁,让各国政府、科研机构和企业,意识到需要建立一个全球性的暂停机制和监管体系,在这段缓冲期内,不只是停下研发。 更重要的是制定标准、完善检测手段、明确责任归属,以及建立全球合作机制,确保AI的行为在可控范围内。 要理解这份呼吁的分量,需要看背后的数据和趋势。近几年,人工智能的算力和算法更新速度呈现指数增长。 AI系统的自我学习能力已经让一些企业和科研团队感到紧张,一个AI模型在几周甚至几天内,就能掌握大批量数据、优化算法策略,形成复杂决策链条。 除了技术层面的考虑,这次呼吁还有更深的社会因素。AI一旦失控,不仅是科技问题,更是伦理、法律和社会治理的问题。 比如,AI可能在不知不觉中加剧社会不平等,或者在决策过程中引入偏见,甚至影响国家安全。 科学家们担心,如果在没有全球共识和监管体系的情况下贸然推进超级智能AI研发,那么一旦出现不可控事件,影响范围将不仅仅局限于科技圈,而是整个社会、整个世界。 另外,这次联名的特殊性也值得注意:3000多名顶尖人物齐声呼吁,显示出他们对当前技术发展趋势的高度共识。 这不仅是一次学术上的倡议,也是向全球政府和企业的紧急提醒,AI已经不是实验室里的课题,它已经进入社会的核心环节,每一步发展都可能引发全球影响。 当然,这份呼吁也引发了不同声音。有些科技公司和投资机构认为,暂停研发会拖慢创新步伐,可能导致技术落后或市场竞争力下降。 但科学家们的观点是,这不是阻止创新,而是让创新更安全、更可持续。短期的暂停,并不会阻挡技术的长期发展,反而可能减少未来更大范围的风险和损失。 可以想象,未来几个月甚至几年内,全球关于AI监管和治理的讨论将会更加激烈。从技术标准制定到伦理框架建立,再到跨国合作机制完善,这一切都需要各国政府、科研机构和企业通力合作。 科学家们的紧急呼吁,其实就是在喊:“别等出事了才反应!”而这也是AI技术发展到一定阶段必然出现的提醒,技术越强大,人类越要学会自我约束。 这次事件的重要性不在于“暂停不暂停”,而在于它给整个社会敲响了一记警钟。超级智能AI的潜力巨大,但潜在风险同样不可忽视。 顶尖科学家和科技大佬的联名呼吁,折射出技术发展与监管之间的紧张关系,也提醒我们未来的技术革命,不能只靠速度和算力,更需要伦理、法律、社会治理和全球协作作为支撑。

![笑死,卢总转了AI的回复[笑着哭]虽然评论很到位](http://image.uczzd.cn/633327315126983122.jpg?id=0)