【开源模型追上闭源了?恐怕没这么简单】

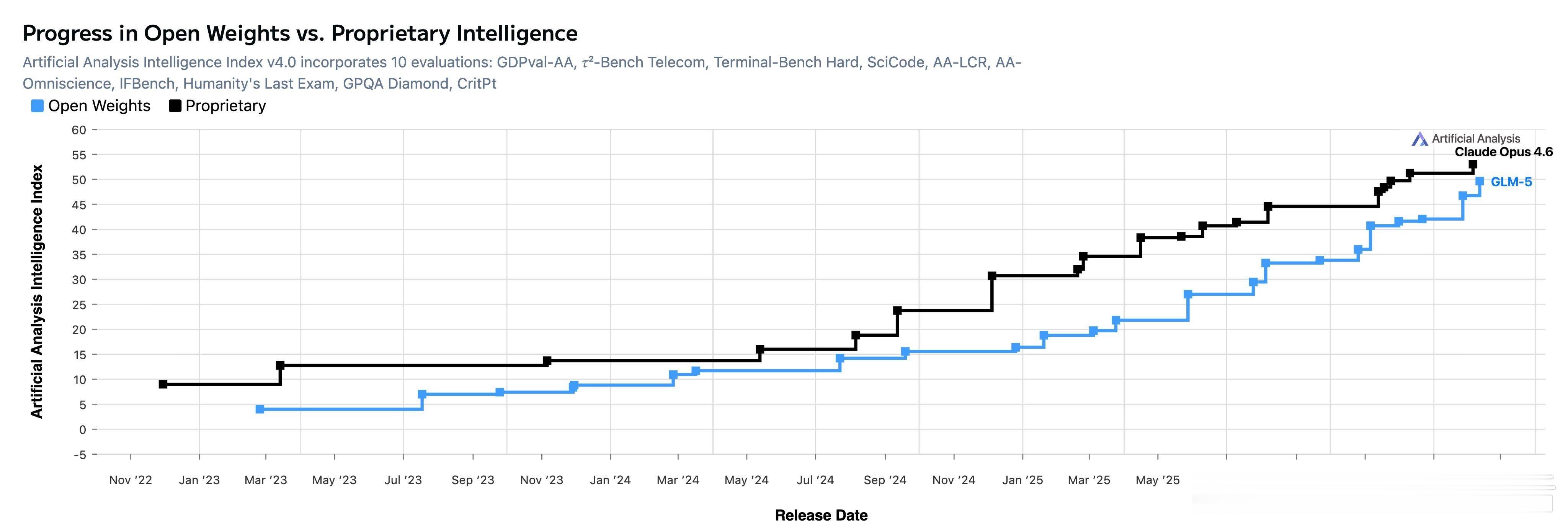

Artificial Analysis 最新图表显示,GLM-5 与 Claude Opus 4.6 的差距已缩小到历史最低点。开源社区一片欢腾,但真相远比图表复杂。

先说结论:跑分在收敛,体验在分化。

跑分榜上,开源模型确实在逼近闭源。但换到 SWE-Rebench 这种实战编码测试,Opus 4.6 排第二,GLM-5 排第十四。差距是真实的。一位长期使用两类模型的开发者说得直白:GLM-5 和 Kimi K2.5 大概接近 Sonnet 4.5 的水平,离 Opus 4.6 还差得远。看看 Opus 的推理 token 效率,看看它适应对话的速度,差距一目了然。

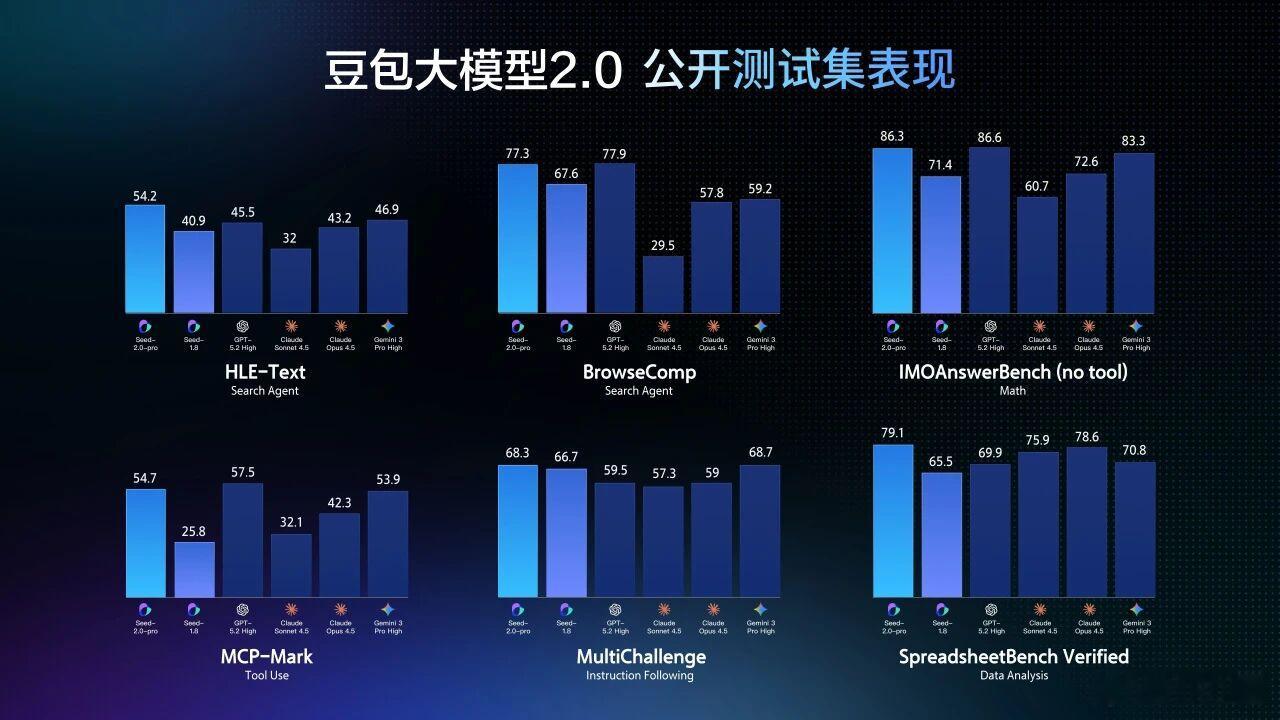

但这不意味着开源没有价值。恰恰相反,对于 70% 到 80% 的生产任务,分类、摘要、翻译、数据提取,开源模型的表现与闭源几乎没有区别。真正拉开差距的是那 10% 到 20% 的硬骨头:复杂的多步推理、需要架构决策的代码生成、细微差别决定成败的分析任务。

两年前你只能选 GPT-4,现在你有五六个真正能打的选项。竞争正在压低价格,打破锁定。这才是开源追赶带来的最大红利。

跑分趋同是事实,但跑分不是全部。模型好不好用,最终还是要看它能不能在你的真实任务里稳定输出。

智谱Claude

reddit.com/r/LocalLLaMA/comments/1r44fzk/the_gap_between_openweight_and_proprietary_model