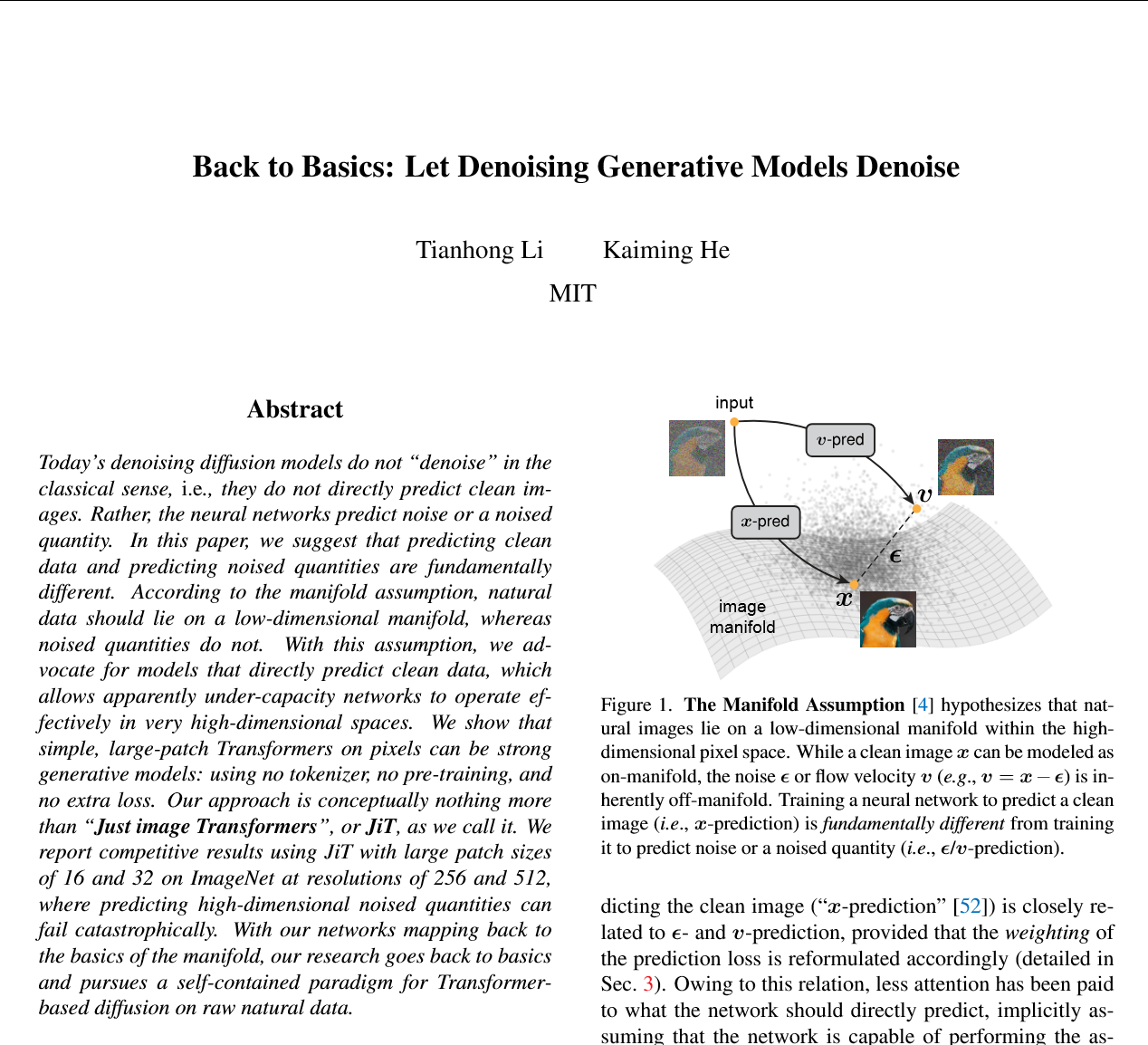

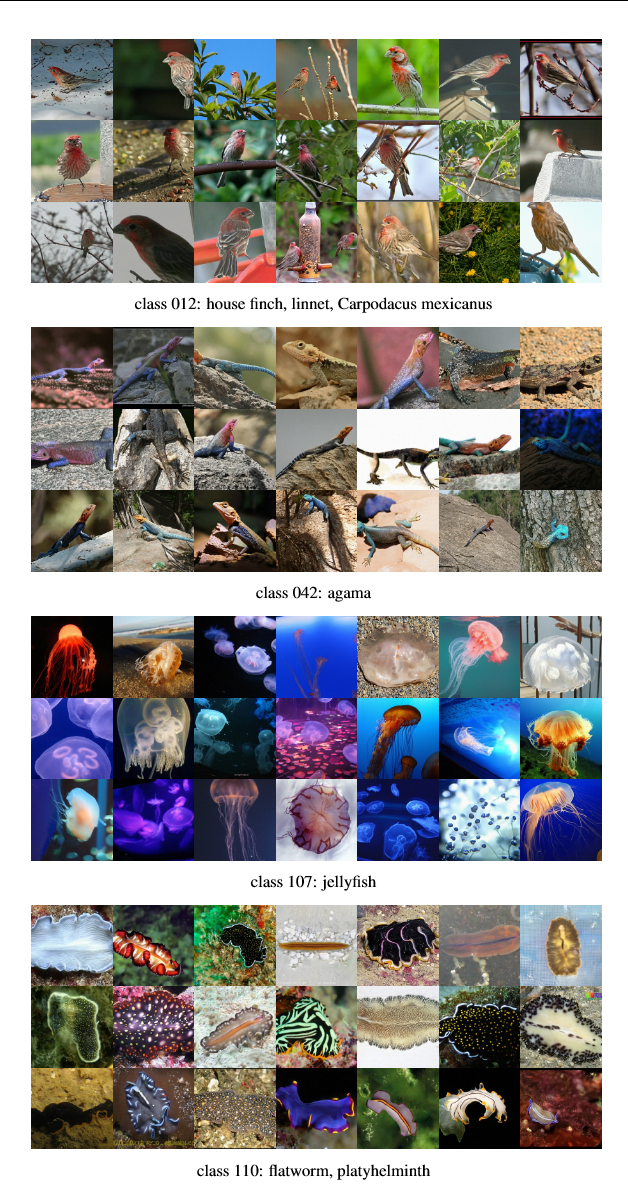

AI大佬何凯明、黎天鸿发新论文了!回归本源:让降噪生成模型(真正)降噪arxiv.org/abs/2511.13720----------------附带下AI解读:当你看到一个由AI生成的精美图像时,它很可能是通过“扩散模型”制作的。这个过程很有趣,它不是一步到位,而是从一张“纯噪音”(像电视雪花)的图像开始,然后“逐步降噪”,直到清晰的图像浮现。训练模型时,主流的方法是这样做的:1️⃣拿一张清晰的图像(我们称之为 x)。2️⃣往上面添加一定量的随机噪音(我们称之为 epsilon)。3️⃣得到一张“带噪音的”图像(我们称之为 z_t)。4️⃣然后,要求神经网络(模型)来预测它刚刚被添加的那个“噪音 epsilon”。这个方法在技术上被称为 epsilon-prediction(噪音预测)。还有一个类似的主流方法叫 v-prediction(速度预测),它预测的是一个混合了清晰图像和噪音的量。关键点是:在这些主流模型中,神经网络的直接输出目标不是那张清晰的图像 x,而是 epsilon 或 v。但这篇论文站出来说:等一等,这种做法(预测噪音)虽然很流行,但它可能从根本上就是错的,或者说至少是低效的。作者的理由基于一个在机器学习领域很经典的理论——“流形假设”(Manifold Assumption)。什么是“流形”? 你可以把“所有可能的像素组合”想象成一个极其巨大的、高维度的空间(比如一个 256x256 图像就有 256x256x3 = 196,608 维)。 清晰的图像:在所有这些可能性中,那些“有意义的、看起来自然的”图像(比如一张猫的照片、一张人脸)只占了这个巨大空间中一个非常非常小的、具有特定结构的部分。这个“小而有结构”的部分,就被称为“低维流形”。 噪音:而“噪音”的特性是完全随机、无结构的。它不位于这个“流形”上,而是散布在整个巨大的高维空间中。基于这个理论,作者的逻辑变得非常清晰: 预测噪音(主流做法)是困难的:你让一个神经网络去预测一个遍布于整个“高维空间”的、无结构的“噪音”(epsilon)。这要求网络具有极高的“容量”(capacity)来记住和处理所有这些高维信息。 预测清晰图像(作者提倡的做法)是更简单的:你让神经网络直接预测那张“清晰的图像”(x)。因为 x 位于那个“低维流形”上,它的目标是结构化的、维度更低的。网络只需要学会如何从带噪的输入中“过滤掉”噪音,保留那些位于流形上的低维信息。因此,论文倡导,模型应该“回归本源”,直接执行“降噪”这个词的本意:直接预测那张清晰的图像。这个方法在论文中被称为 x-prediction。总结一下:作者认为,让模型去学习预测一个高维、无结构的“噪音”目标,是一种“舍近求远”的低效做法。而让模型回归到预测那个低维、有结构的“清晰图像”目标,在理论上更合理,在实践中(尤其是在处理高维像素数据时)更有效。