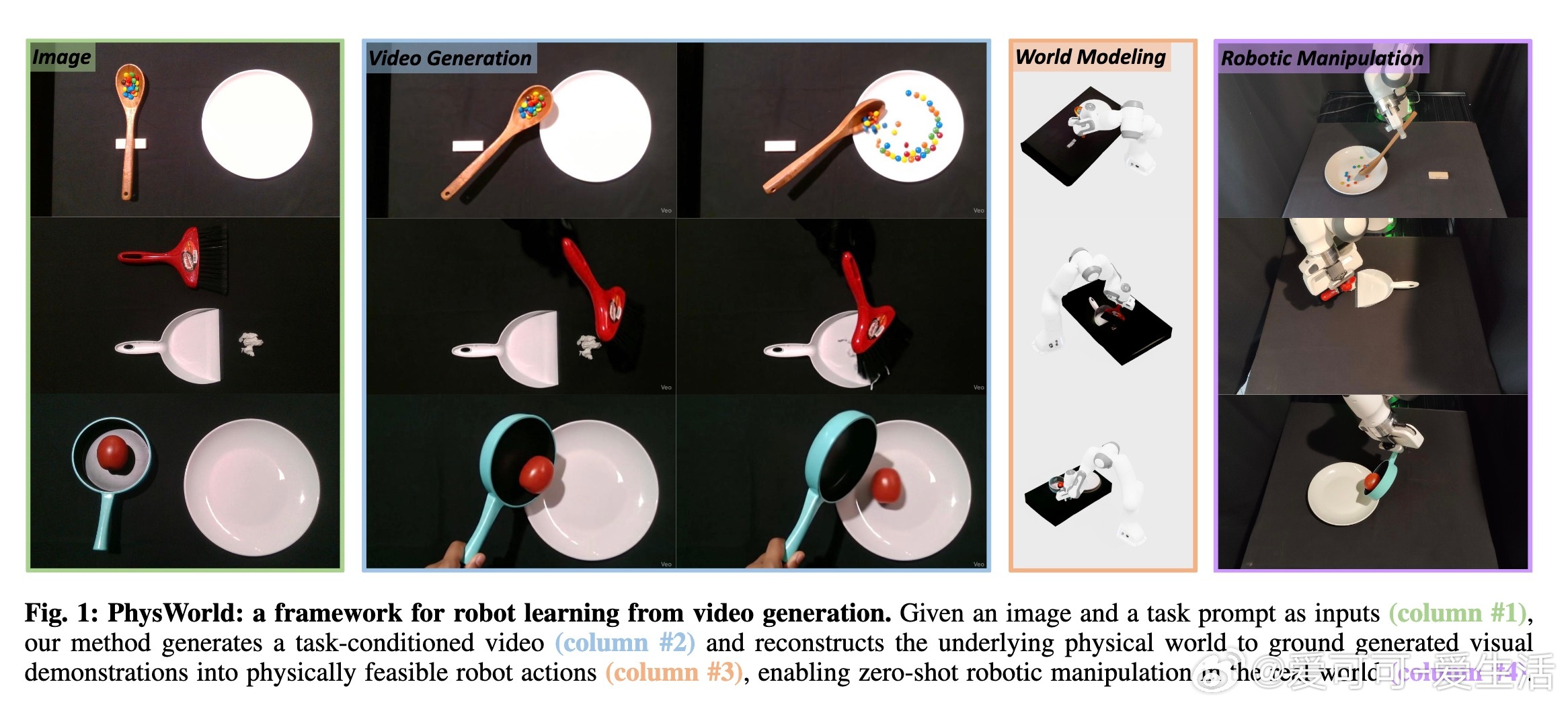

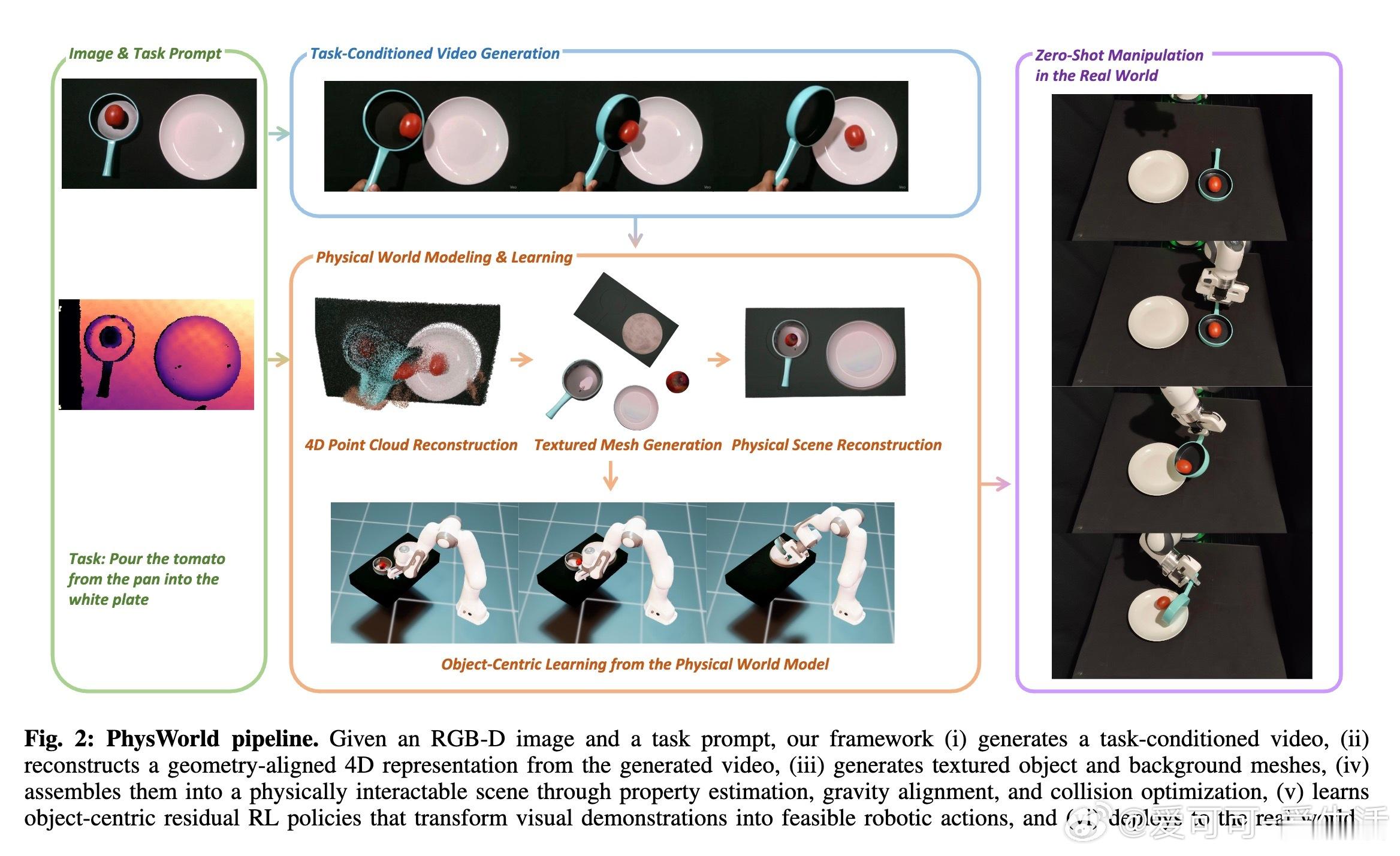

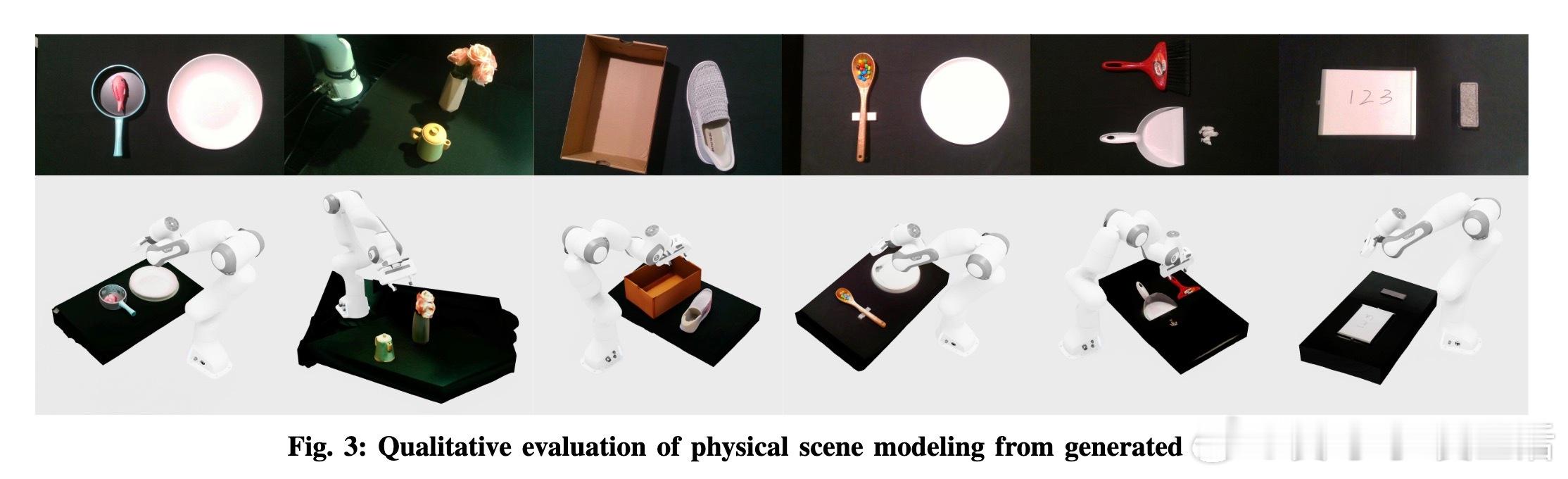

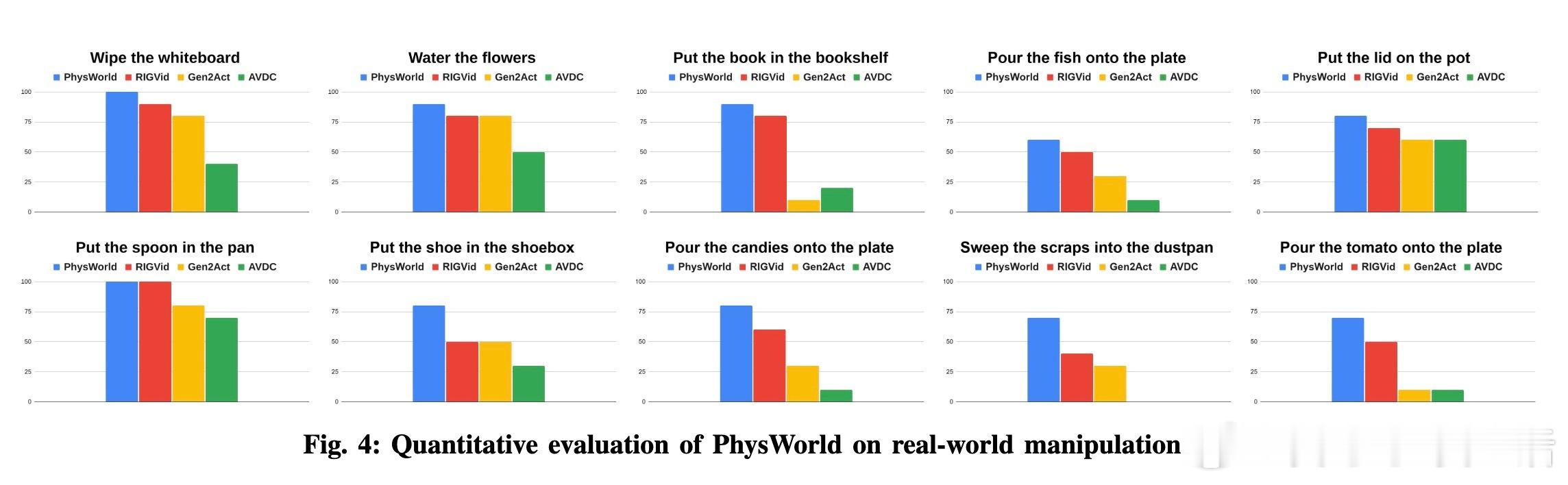

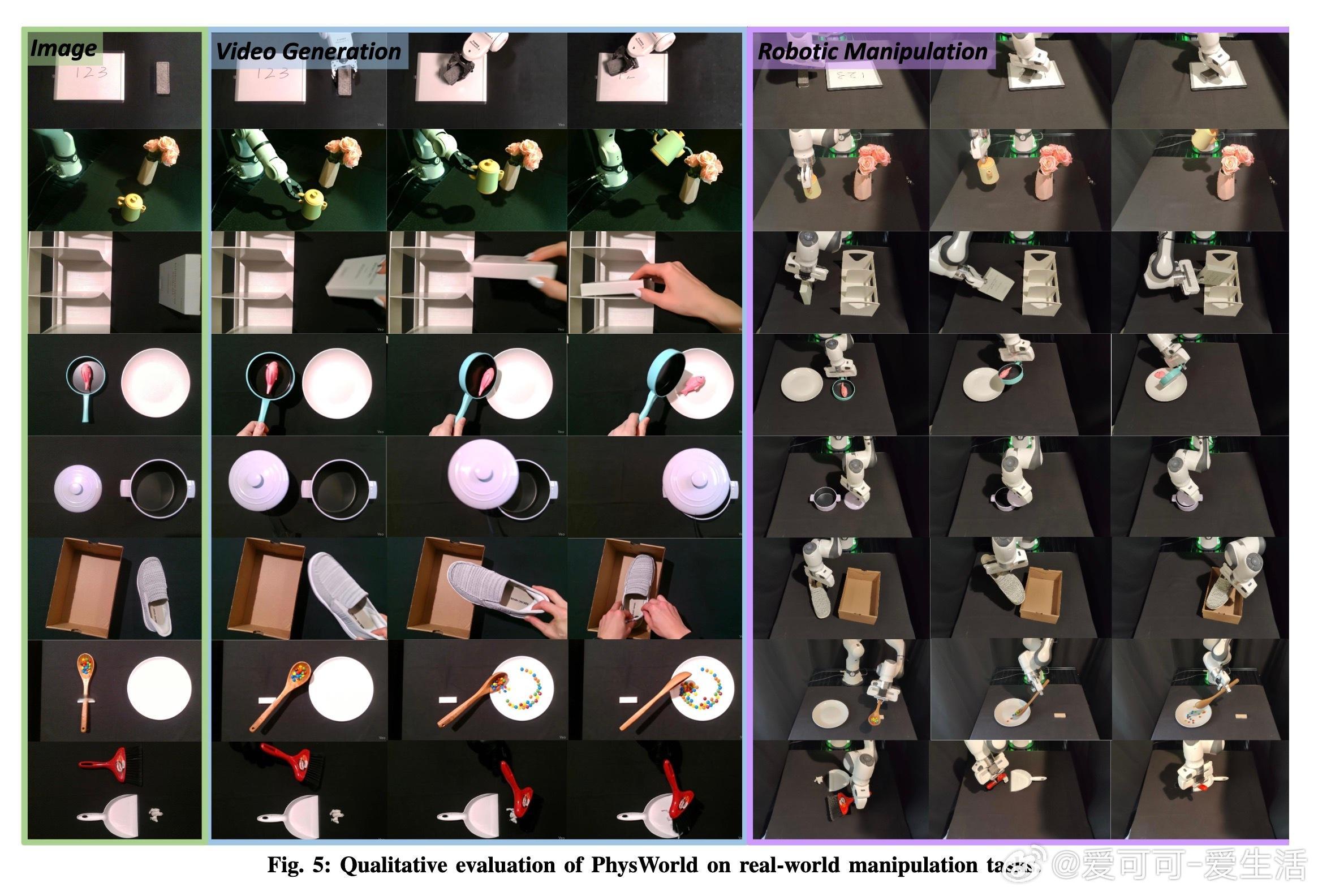

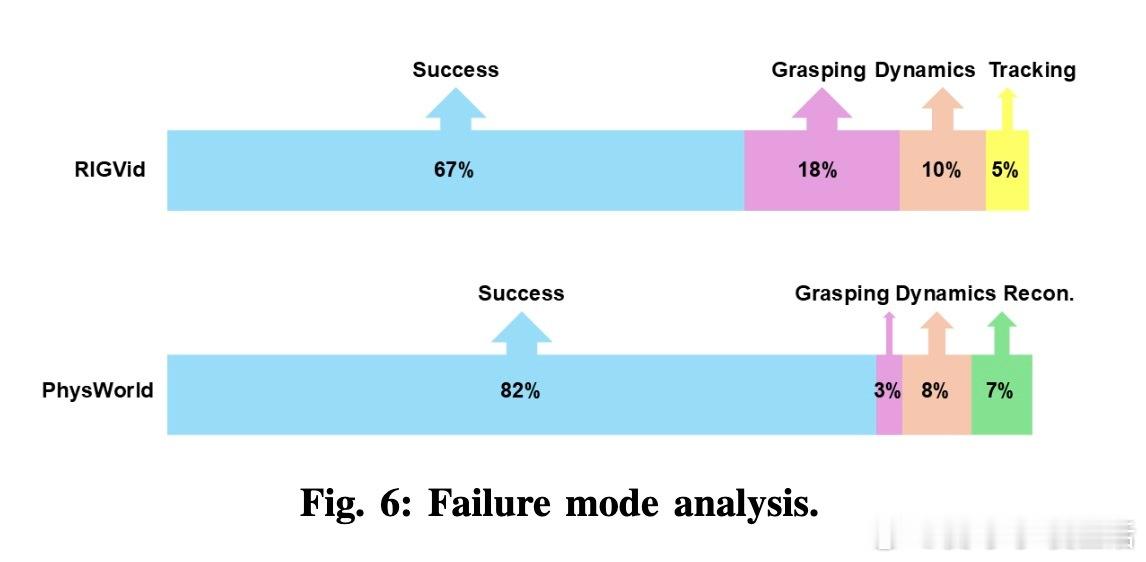

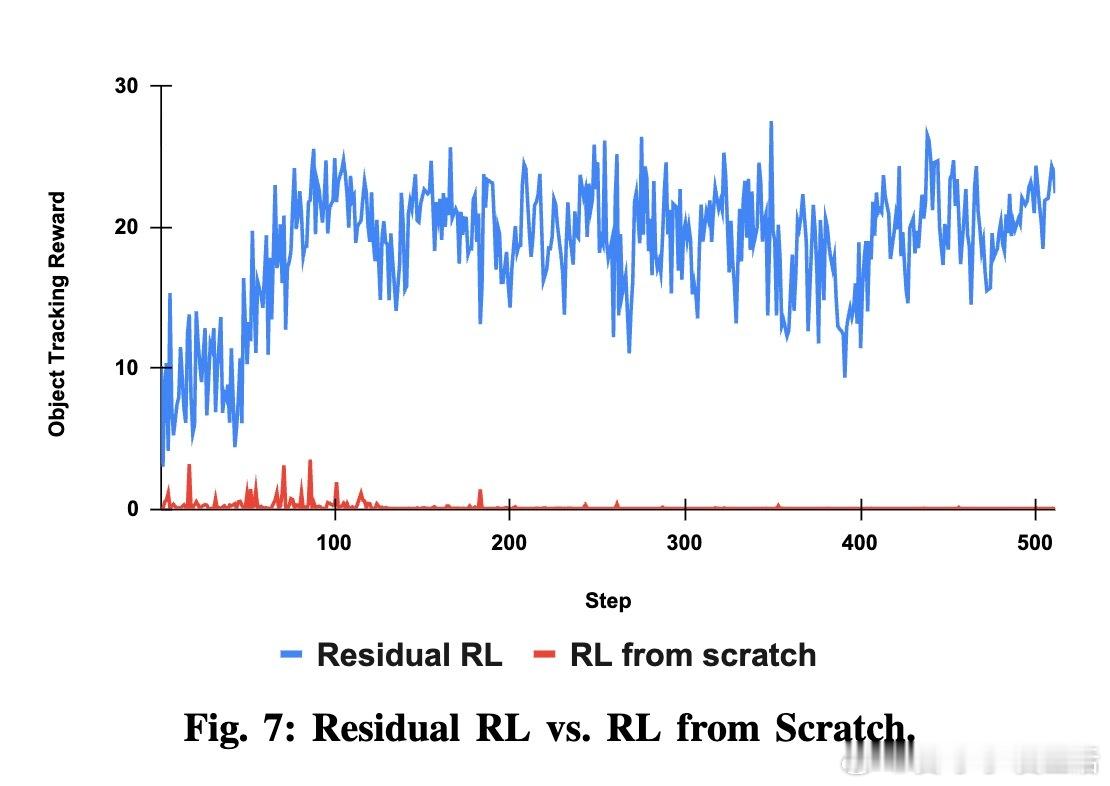

[RO]《Robot Learning from a Physical World Model》J Mao, S He, H Wu, Y You... [Google DeepMind & USC] (2025) 本文提出一种融合视频生成与物理场景重建的机器人零样本学习新框架,开辟机器人自主操控新路径。传统视频生成模型虽能根据图像和语言指令合成逼真示范视频,但直接将像素运动映射为机器人动作忽视了物理约束,导致操作误差大。PhysWorld创新性地从单张RGB-D图像和任务指令出发,先生成任务条件视频,再从视频构建4D时空物理场景,包括纹理网格、质量摩擦等物理属性,利用视觉语言模型辅助赋予物理参数,并通过碰撞优化确保场景物理合理。更关键的是,团队设计了基于物理世界模型的“对象中心残差强化学习”策略,聚焦对象运动轨迹作为学习目标,绕开了生成视频中常见的手部幻觉问题。该策略结合基线抓取与路径规划动作,学习残差修正,显著提升了策略收敛速度与鲁棒性,实现了无需真实机器人示范数据的零样本泛化操作。实验证明,PhysWorld在多样化真实任务(如倒番茄、放书入架、浇花等)中成功率达82%,较现有纯视觉追踪方法提升15%以上,有效减少抓取失败和运动追踪误差。通过对比多款视频生成模型,研究指出高质量、任务一致的视频生成是实现精确操控的关键。这项工作不仅打开了机器人学习利用大规模互联网视频生成模型的新思路,也为物理模拟与视觉生成的深度融合树立了标杆。未来,PhysWorld有望推动机器人自主适应复杂物理环境,摆脱昂贵示范采集限制,加速智能机器人在实际生活场景中的落地应用。详细内容请见:arxiv.org/abs/2511.07416