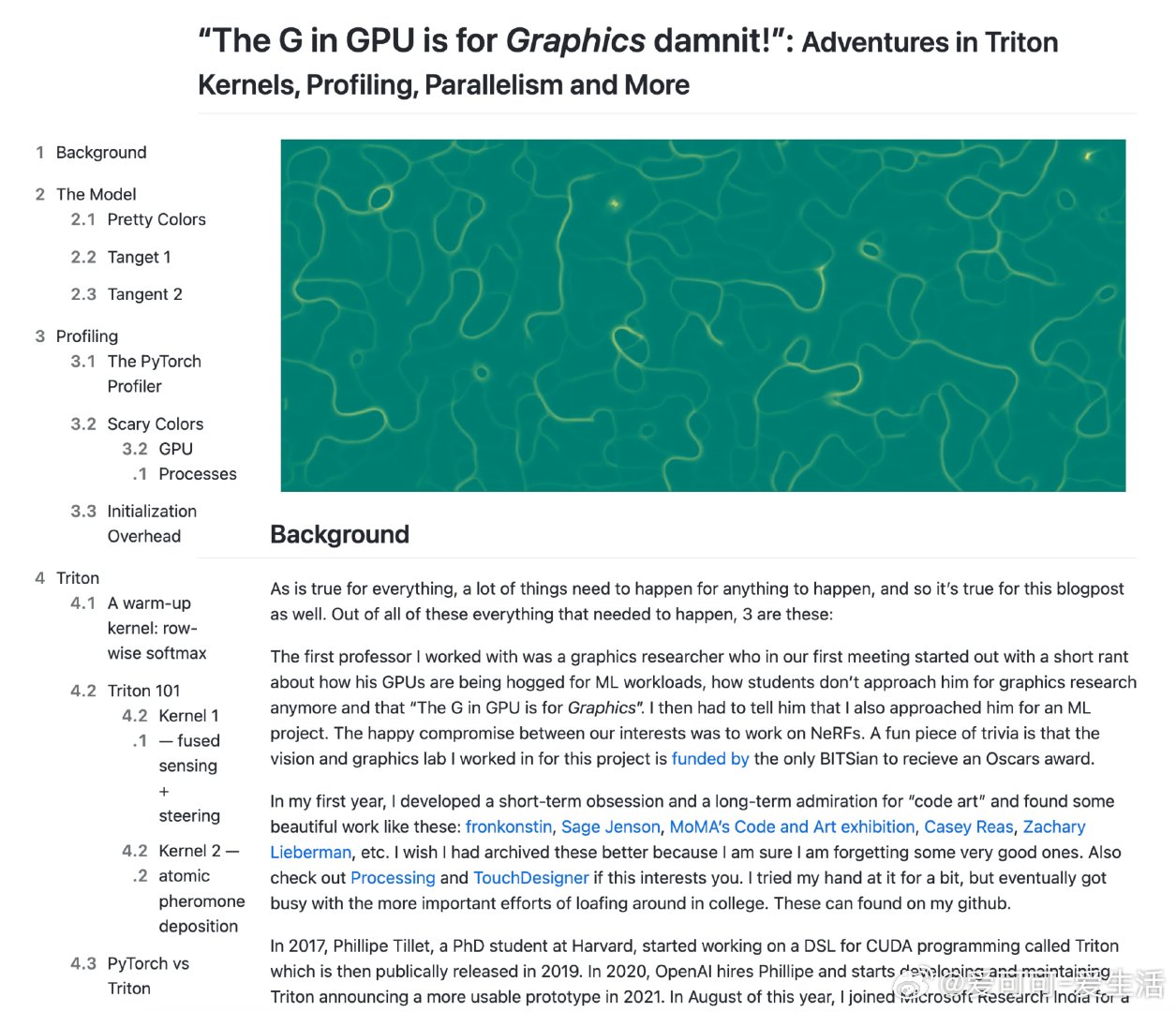

《“The G in GPU is for Graphics damnit!”: Adventures in Triton Kernels, Profiling, Parallelism and More》

“GPU的G就是Graphics!”——Triton内核、性能剖析与并行计算探险记

在GPU被机器学习占领的今天,别忘了它最初为图形渲染而生。本文作者从视觉图形研究切入,结合Physarum(一种模仿真菌生长的模型)模拟,深入探索GPU上的高效并行计算与优化。

Physarum模型简介:

- 由agent和pheromone两层格点构成,agent根据周围信息素浓度移动并留下轨迹。

- 模拟过程包括感知、转向、移动、信息素释放、扩散与衰减五步,简单却能生成复杂图案。

- 可用PyTorch实现,但存在性能瓶颈。

性能剖析与优化思路:

- 仿真时间随步数线性增长,随网格大小近似二次增长,agent数量影响较小。

- PyTorch Profiler揭示首步初始化开销巨大,后续调用效率提升。

- 细粒度时间记录帮助锁定性能瓶颈,指导后续优化。

Triton的引入与优势:

- Triton是介于PyTorch和CUDA之间的领域专用语言,用Python风格写GPU内核,简化CUDA编程复杂度。

- 支持JIT编译,内核首次调用时生成高效PTX代码,后续直接调用,极大提升运行效率。

- 通过融合感知、转向和移动操作为单次内核调用,避免中间数据写回全局内存,提升缓存利用。

- 采用原子操作实现信息素高效累加,减少内存访问冲突。

数学建模与算法敏感性分析:

- 通过简化线性模型和Lyapunov指数,证明系统对初始条件高度敏感,体现伪随机性,适合模拟复杂结构生成。

- 这种敏感性为基于初始图像的加密等应用打开可能。

思考与启示:

- GPU不仅是机器学习的加速器,更是图形与复杂系统模拟的强大平台。

- 领域专用语言如Triton让专业加速更普及,促进算法创新与性能提升。

- 性能剖析工具和数学理论相结合,为优化提供科学指导。

- 未来可探索更多复杂初始条件与多样化扩散机制,丰富模拟表现力。

本文不仅展示了从模型设计到性能调优的完整路径,也体现了跨学科知识融合在计算创新中的力量。

原文链接:ut21.github.io/blog/triton.html