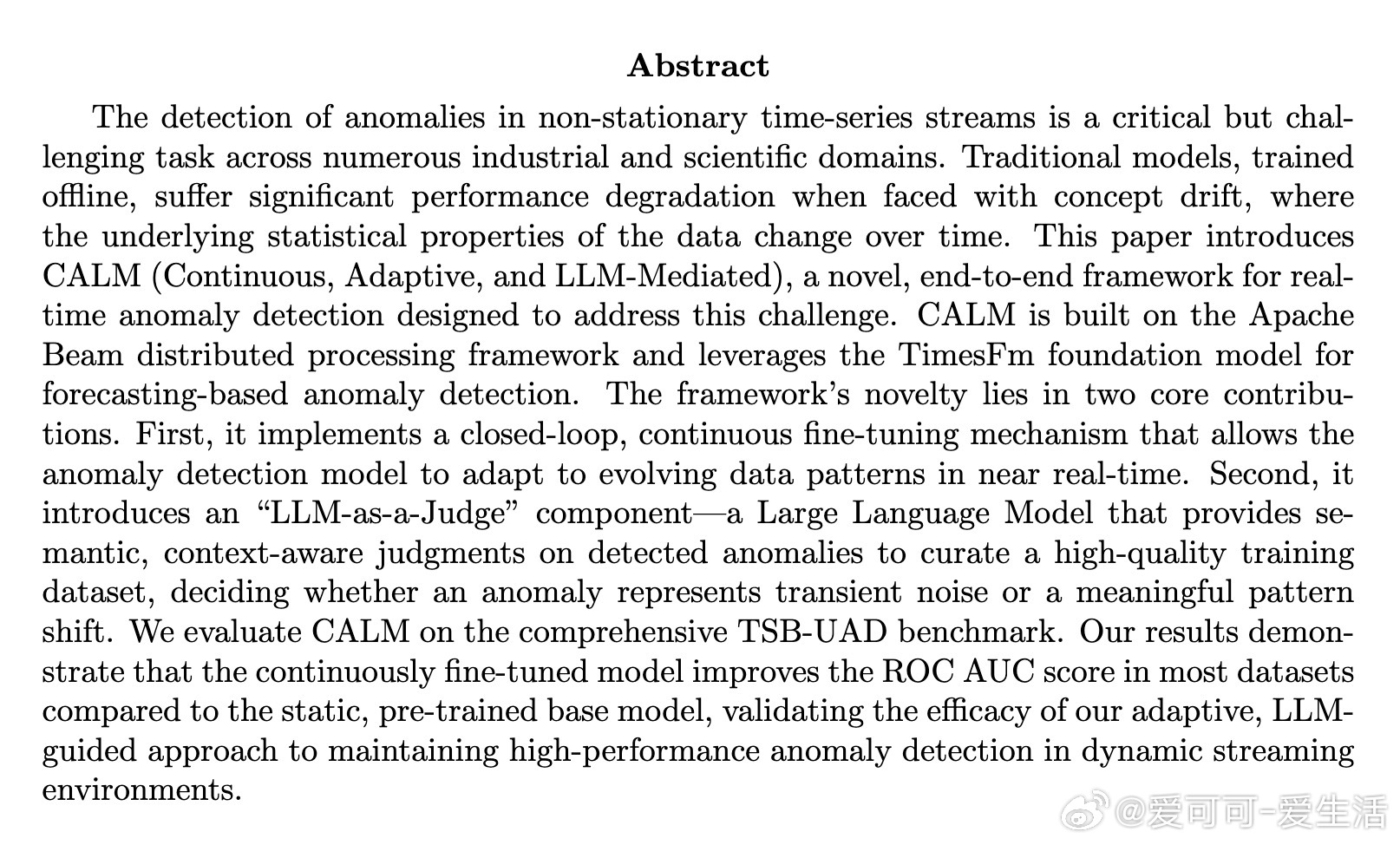

[LG]《CALM: A Framework for Continuous, Adaptive, and LLM-Mediated Anomaly Detection in Time-Series Streams》A Devireddy, S Huang [Dataflow ML Team] (2025)

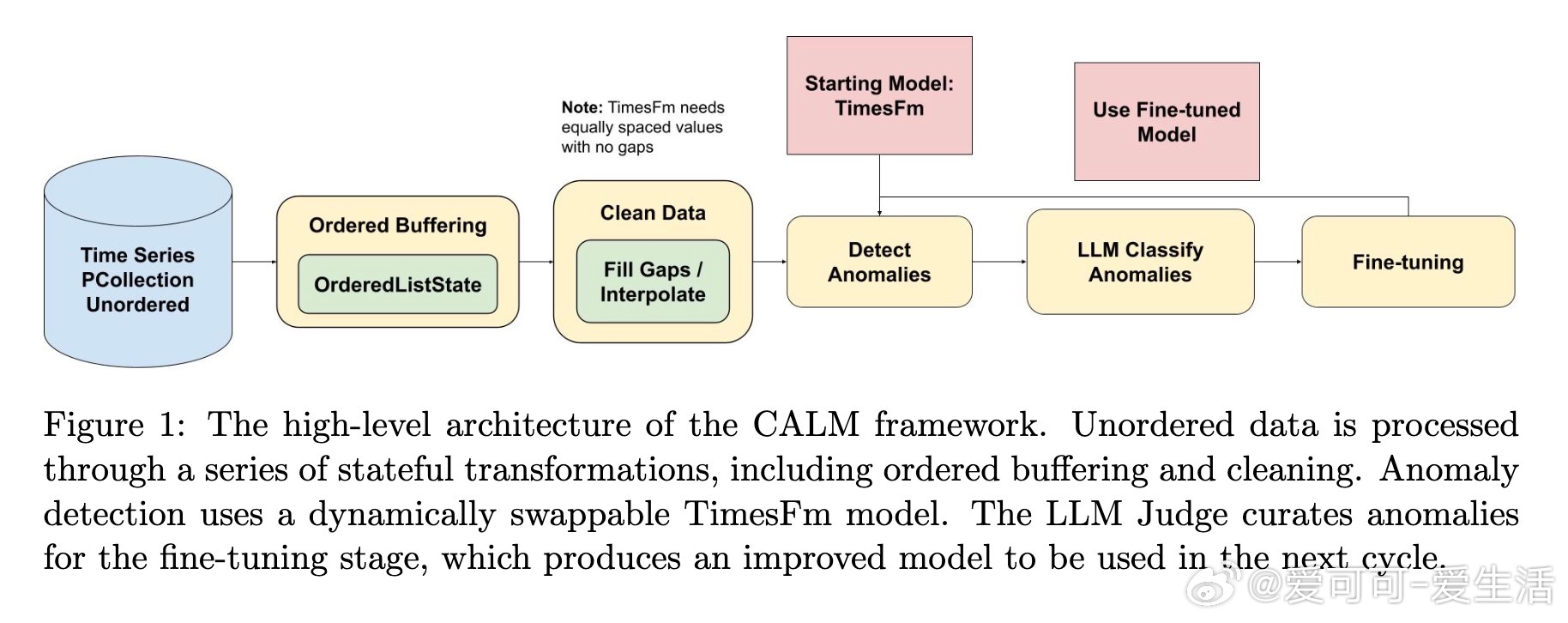

CALM框架:融合Apache Beam流处理、TimesFm基础模型与LLM智能判别,实现时序流中异常的连续自适应检测。

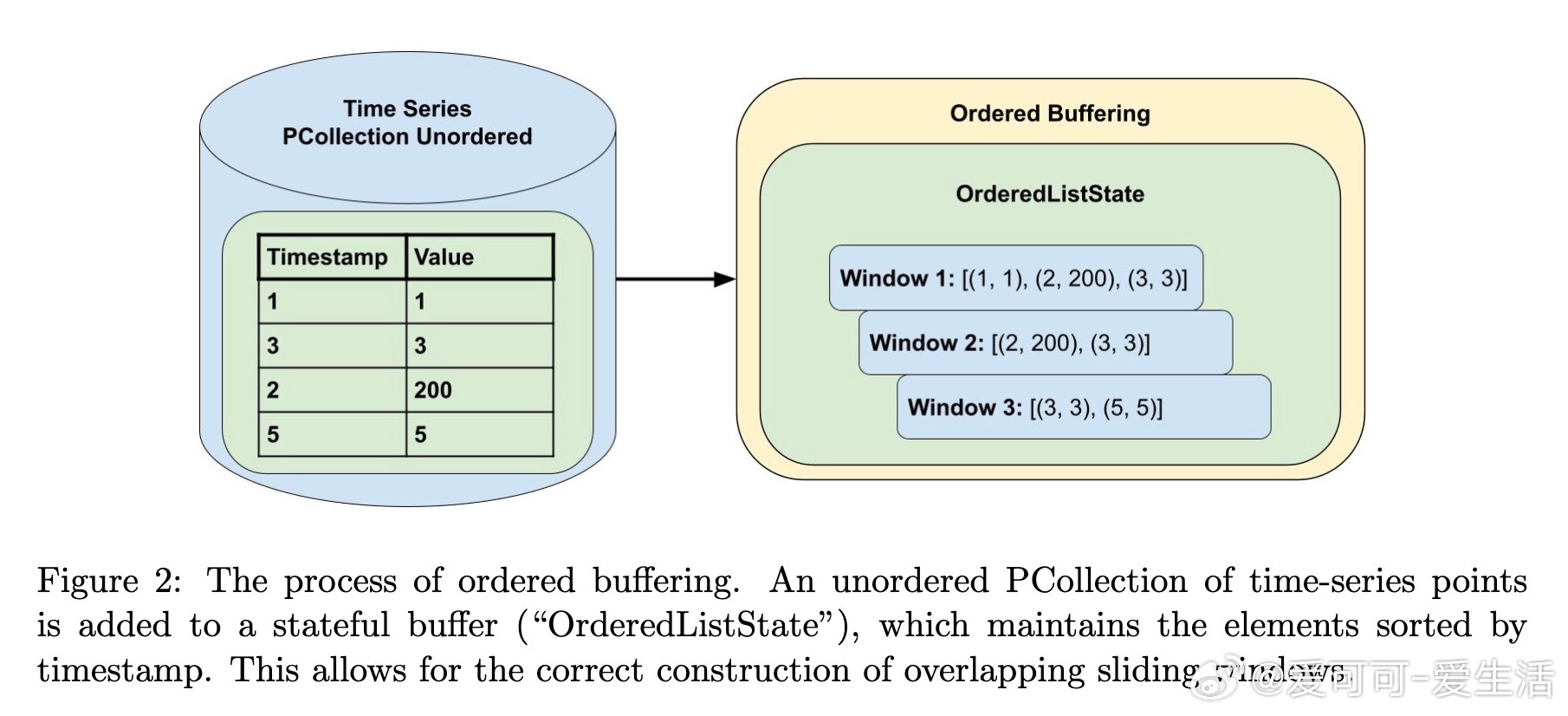

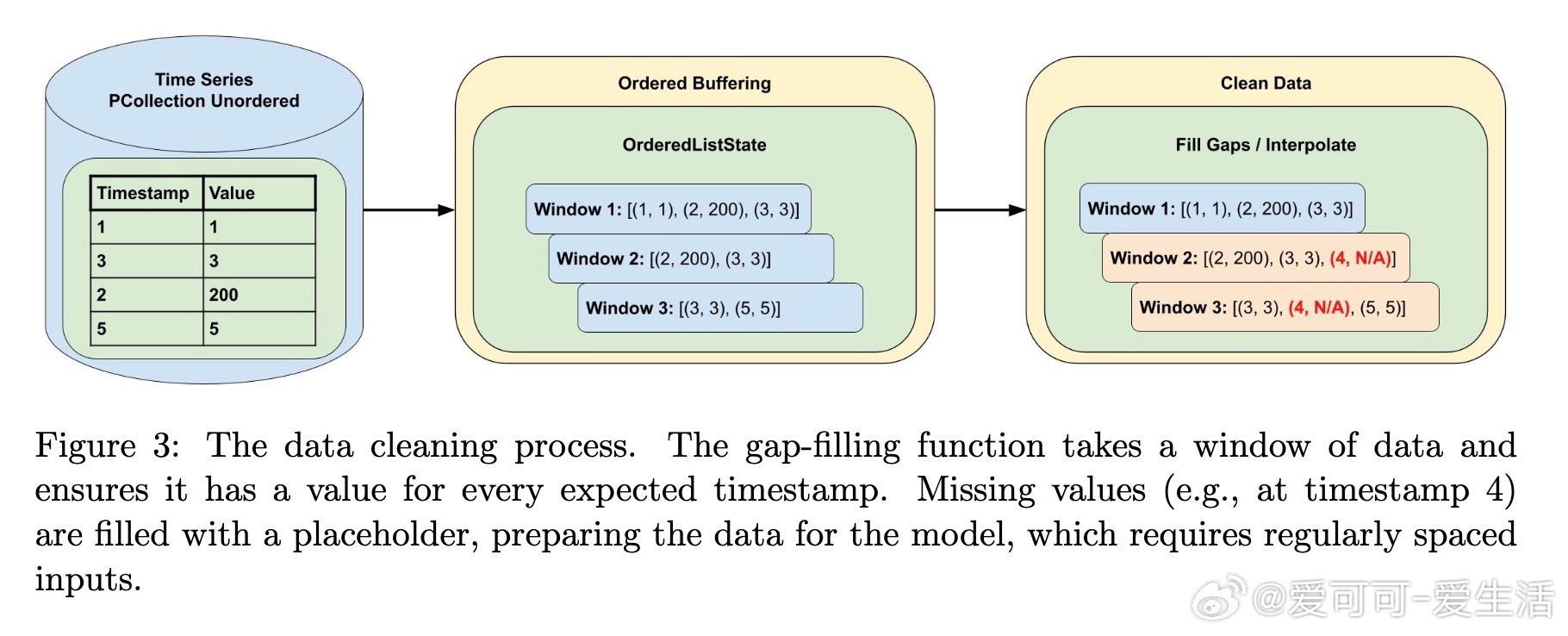

• 端到端流式架构基于Apache Beam,支持高吞吐、乱序数据的状态化窗口处理与数据插值,保障数据质量与实时性。

• 采用TimesFm预训练时序基础模型进行基于预测的异常检测,利用分位数预测动态构建鲁棒阈值,提升异常判定准确度。

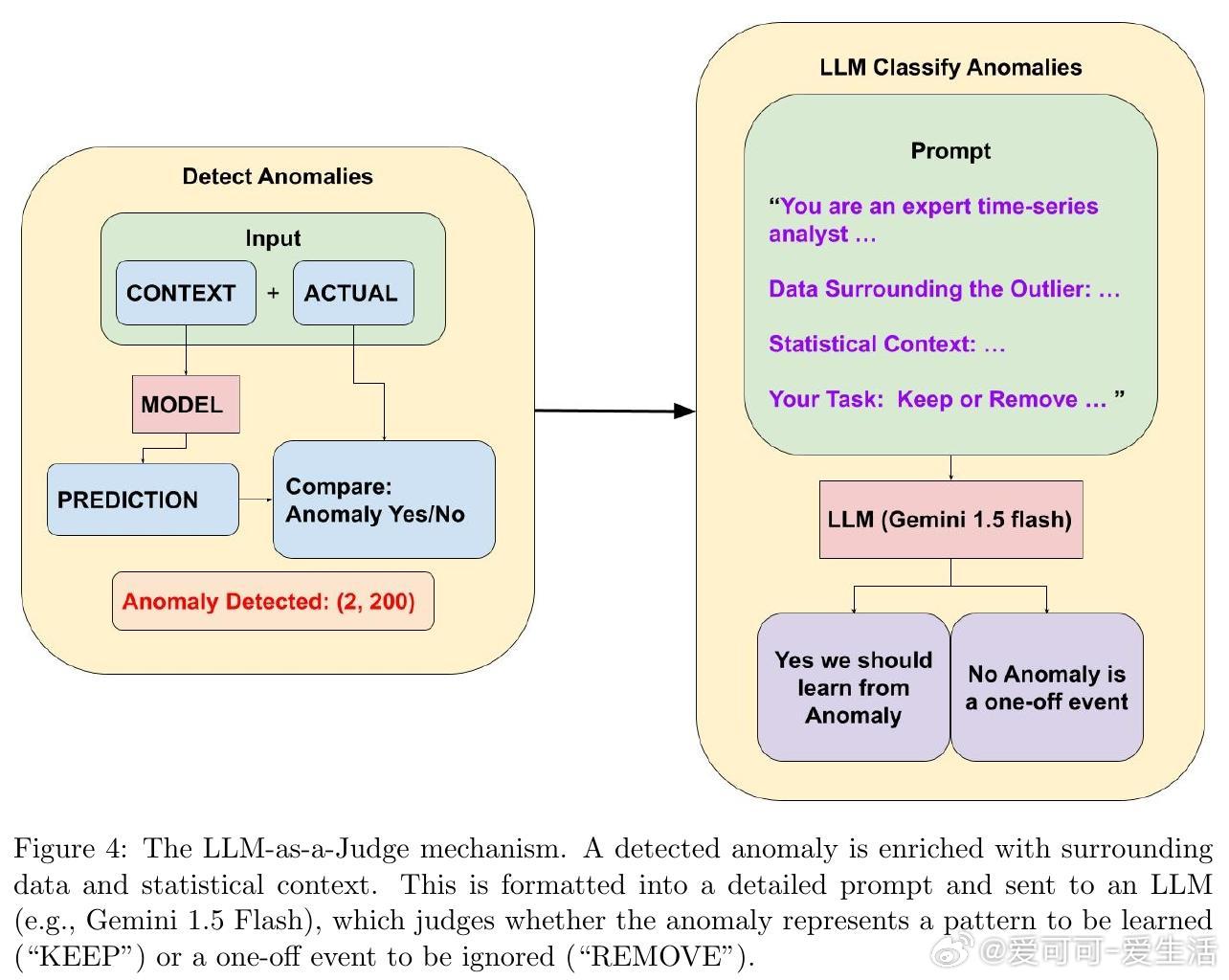

• 创新引入“LLM-as-a-Judge”机制,利用大型语言模型进行语义推理,区分短暂噪声与持续模式转变,实现语义层面漂移检测与高质量训练数据筛选。

• 构建闭环持续微调系统:经LLM筛选的异常数据批量触发模型微调,自动部署新版模型,实现无人工干预的在线自适应,显著缓解概念漂移带来的性能衰退。

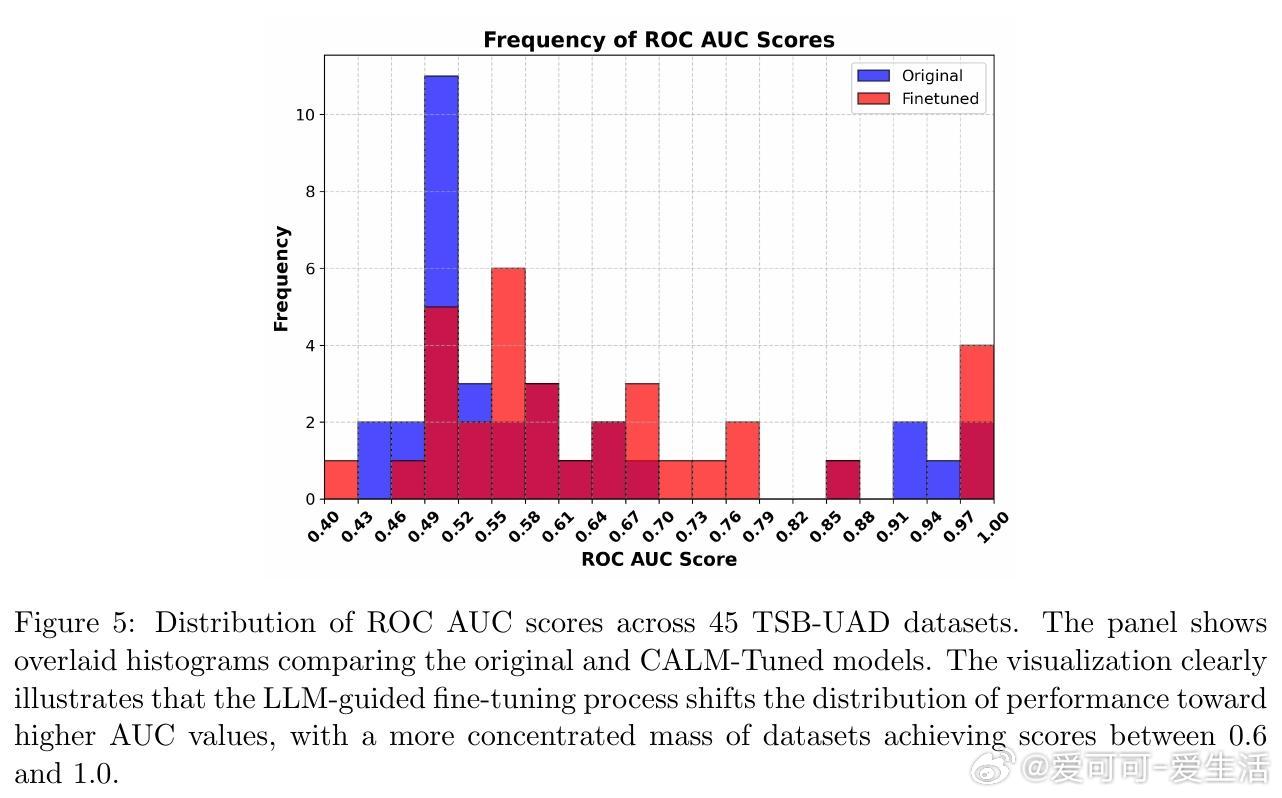

• 实验验证:在TSB-UAD基准33个数据集上,CALM微调模型较静态基线显著提升ROC AUC,特别在原模型表现欠佳的数据上提升幅度最大。

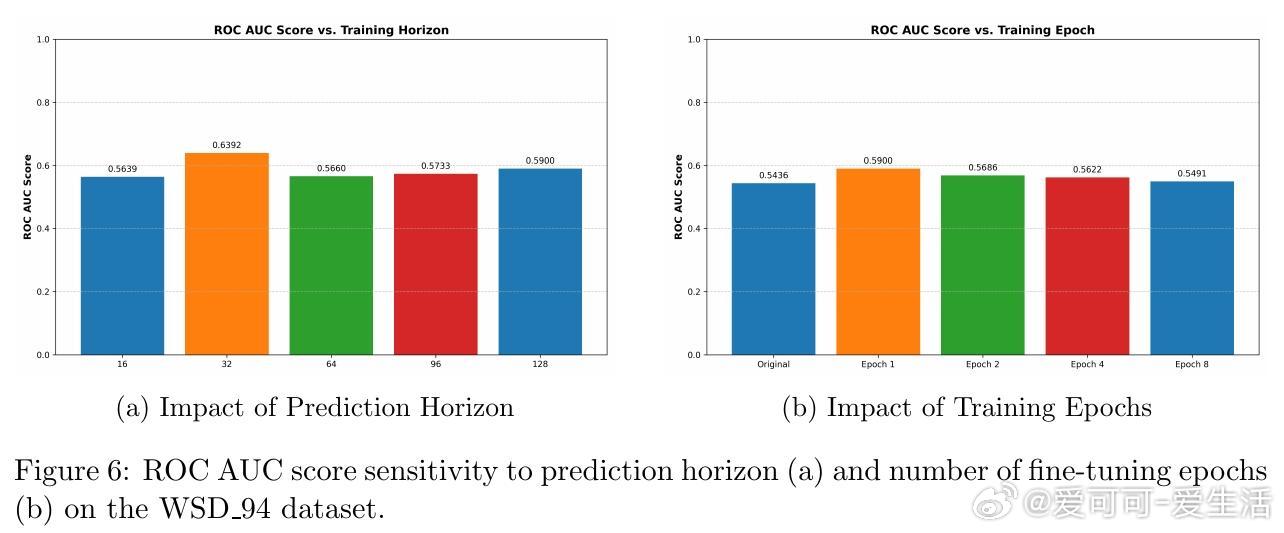

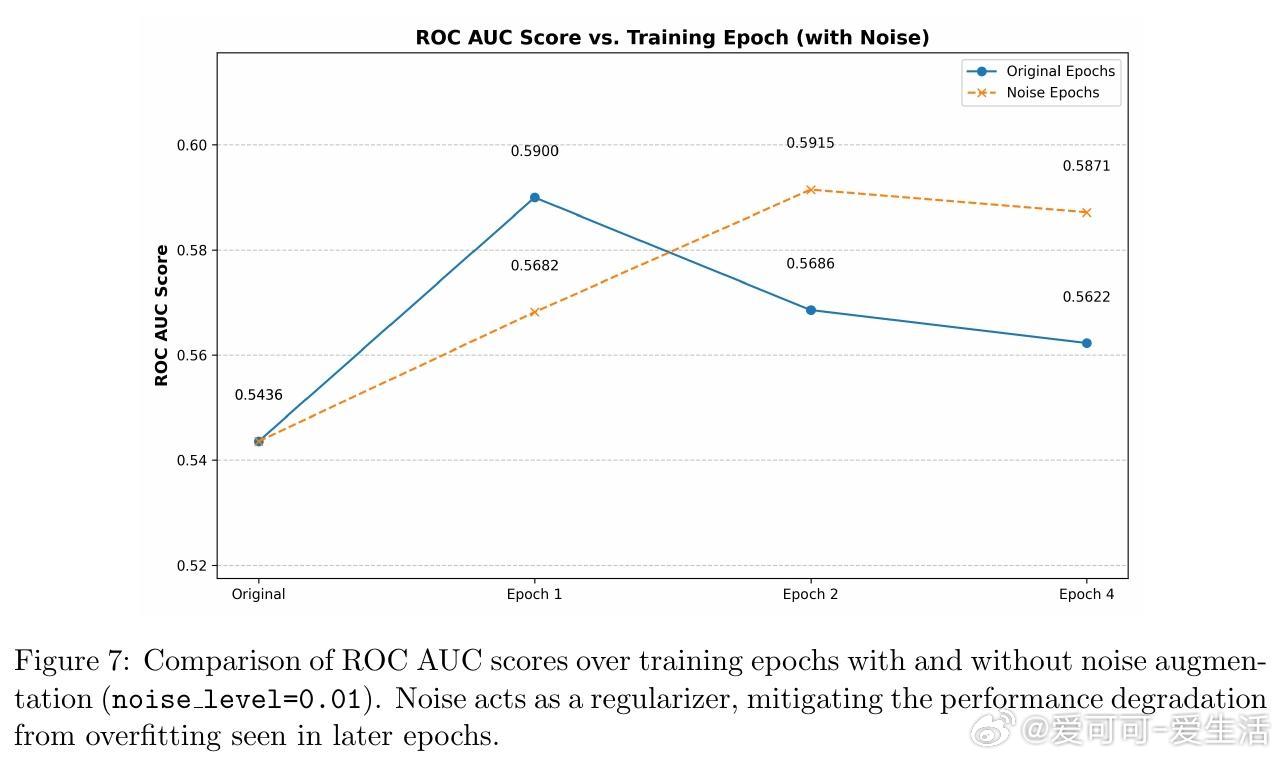

• 灵敏度分析揭示:预测长度和微调轮次对性能影响有限,首轮微调效果最佳,有助防止过拟合;噪声增强正则化可进一步平滑性能曲线。

• 未来发展方向包括多变量时序扩展、参数高效微调(如LoRA)、多轮LLM判决策略提升判别鲁棒性,以及智能微调触发机制优化。

心得:

1. 将LLM用于实时语义判定,突破了传统统计漂移检测的局限,赋能模型自主甄别真正有价值的异常信号。

2. 结合状态化流处理和模型动态热替换,实现了理论与工程的深度融合,保障系统在复杂生产环境中的稳定与灵活。

3. 持续微调闭环不仅提升模型适应性,更推动了机器学习系统由静态工具向智能自治体的进化。

详情🔗 arxiv.org/abs/2508.21273

时序异常检测大语言模型流处理自适应学习机器学习系统