[LG]《Merge-of-Thought Distillation》Z Shen, Z Qin, Z Huang, H Chen... [Zhejiang University & Inclusion AI] (2025)

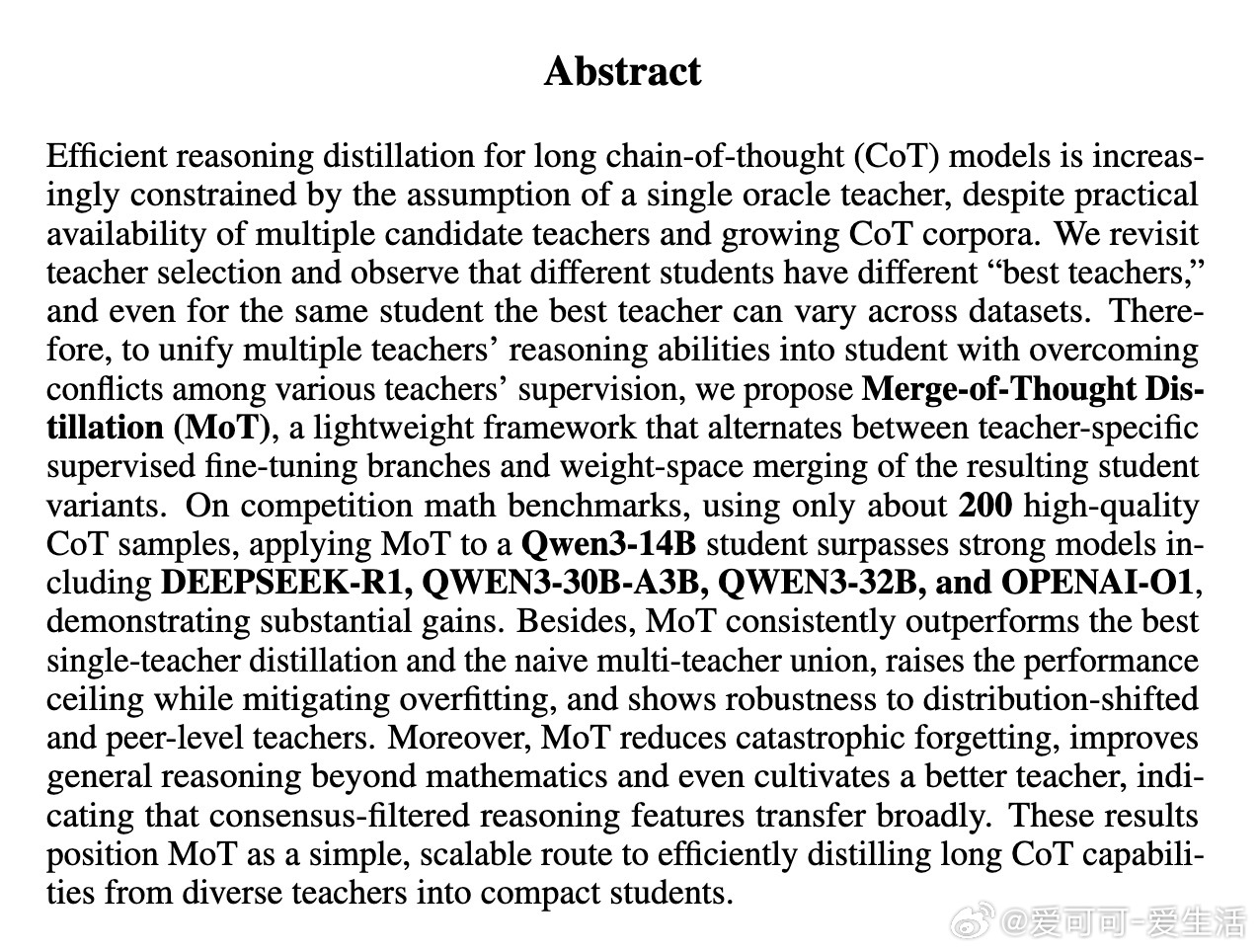

Merge-of-Thought Distillation(MoT)创新性地解决了长链条思维(CoT)模型中多教师融合难题,推动高效推理蒸馏迈出关键一步。

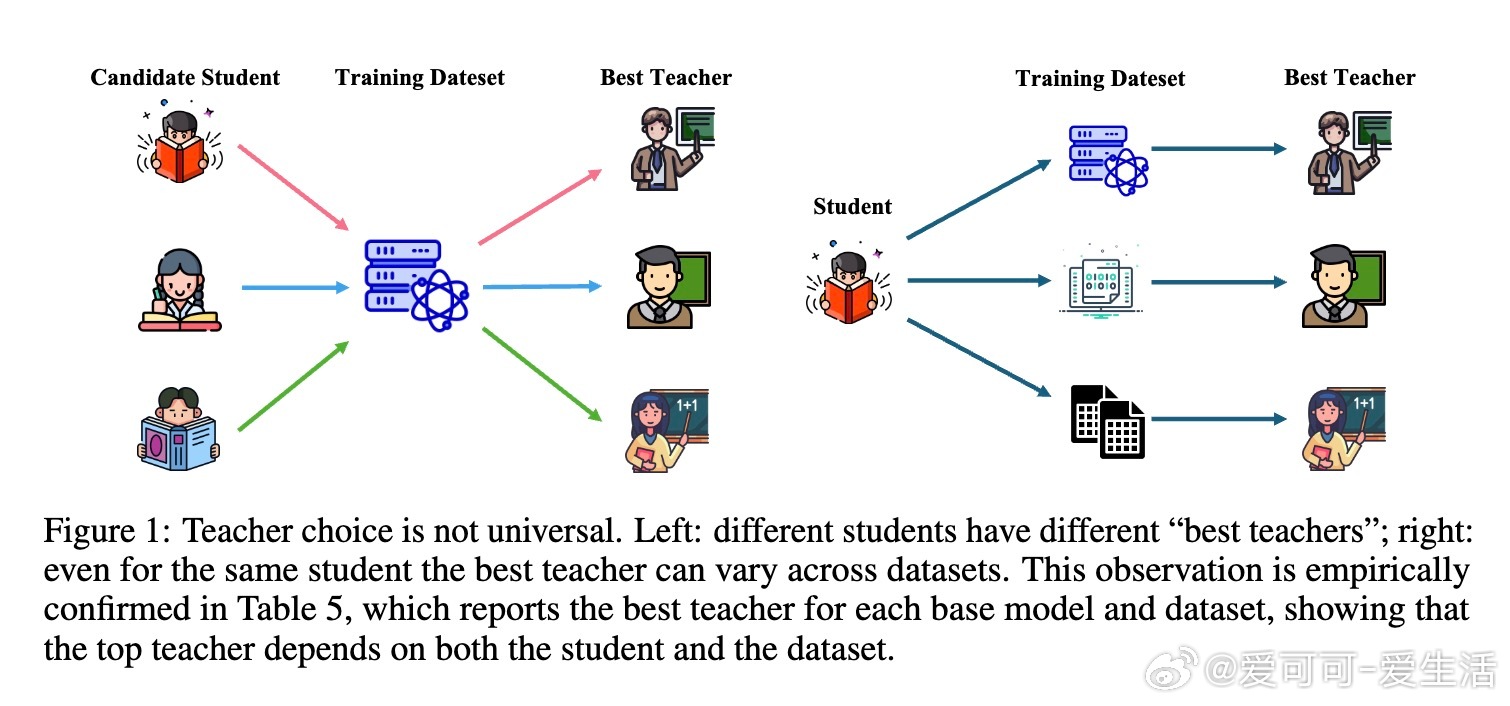

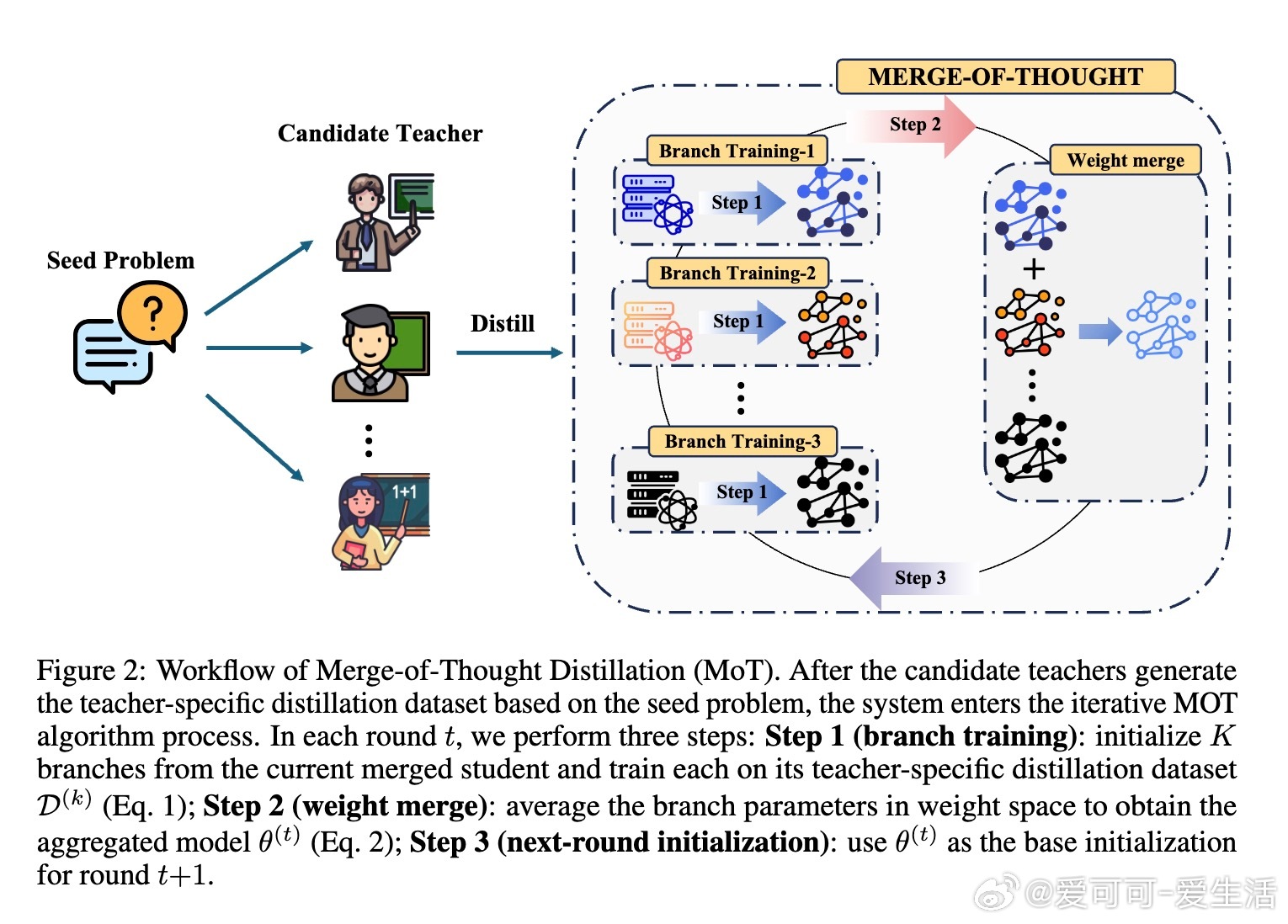

• 颠覆单一最佳教师假设:不同学生和数据集对应不同“最佳教师”,MoT跳出传统教师选择困境,通过交替教师特定分支微调与权重空间合并,实现多教师推理能力的统一与互补。

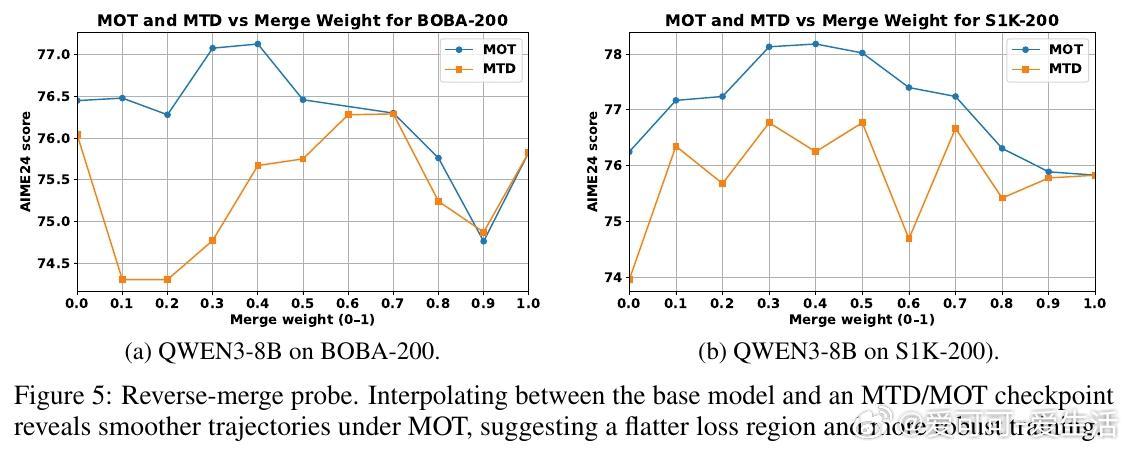

• 轻量级迭代流程:每轮先为各教师构建专属微调分支,再通过参数均值合并,滤除个性化噪声,提炼共识推理特征,持续迭代提升学生模型推理表现。

• 小样本高效:仅凭200条高质量CoT示例,MoT在数学竞赛基准上使Qwen3-14B学生模型超越DEEPSEEK-R1、QWEN3-30B-A3B、QWEN3-32B和OPENAI-O1等强大模型。

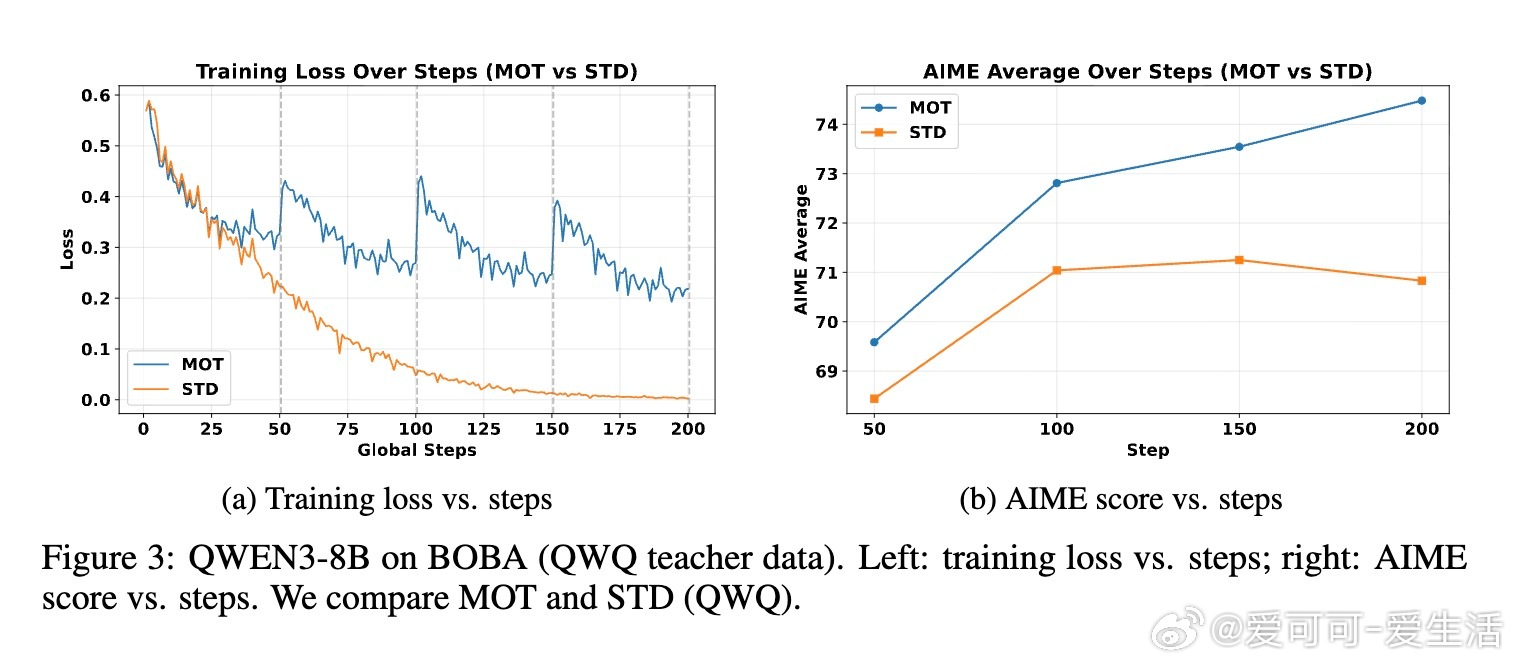

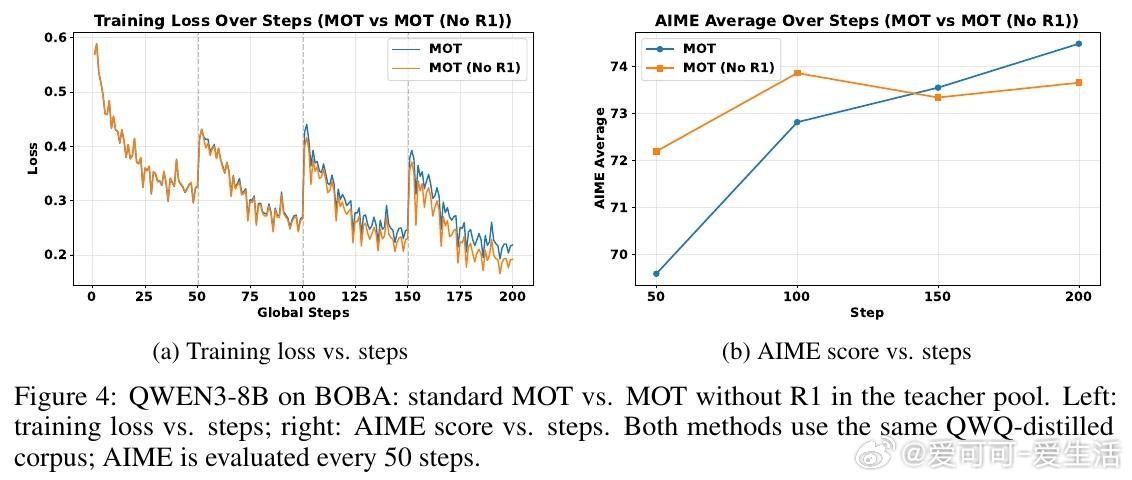

• 超越单教师与简单多教师联合:MoT稳定提高性能上限,有效抑制过拟合,具备对分布漂移教师与同级教师的鲁棒性。

• 减轻灾难性遗忘,强化泛化推理:训练后的MoT模型在多种推理任务上表现更优,且其作为教师能培养出更强的学生,体现出推理共识特征的广泛迁移力。

• 理论与实践创新结合:首次系统研究多教师长链CoT联合蒸馏,结合模型合并技术突破教师监督冲突瓶颈。

心得:

1. 教师多样性是优势非负担,有效融合而非盲目选择是提升模型推理能力的关键。

2. 低训练损失不必然带来更强推理能力,MoT展现了更高的性能天花板和更稳健的训练动态。

3. 模型合并不仅仅是参数叠加,更是去噪与共识提炼的过程,促进了推理能力的普适提升和灾难性遗忘的缓解。

阅读详情🔗arxiv.org/abs/2509.08814

大模型链式思维知识蒸馏模型合并人工智能机器学习