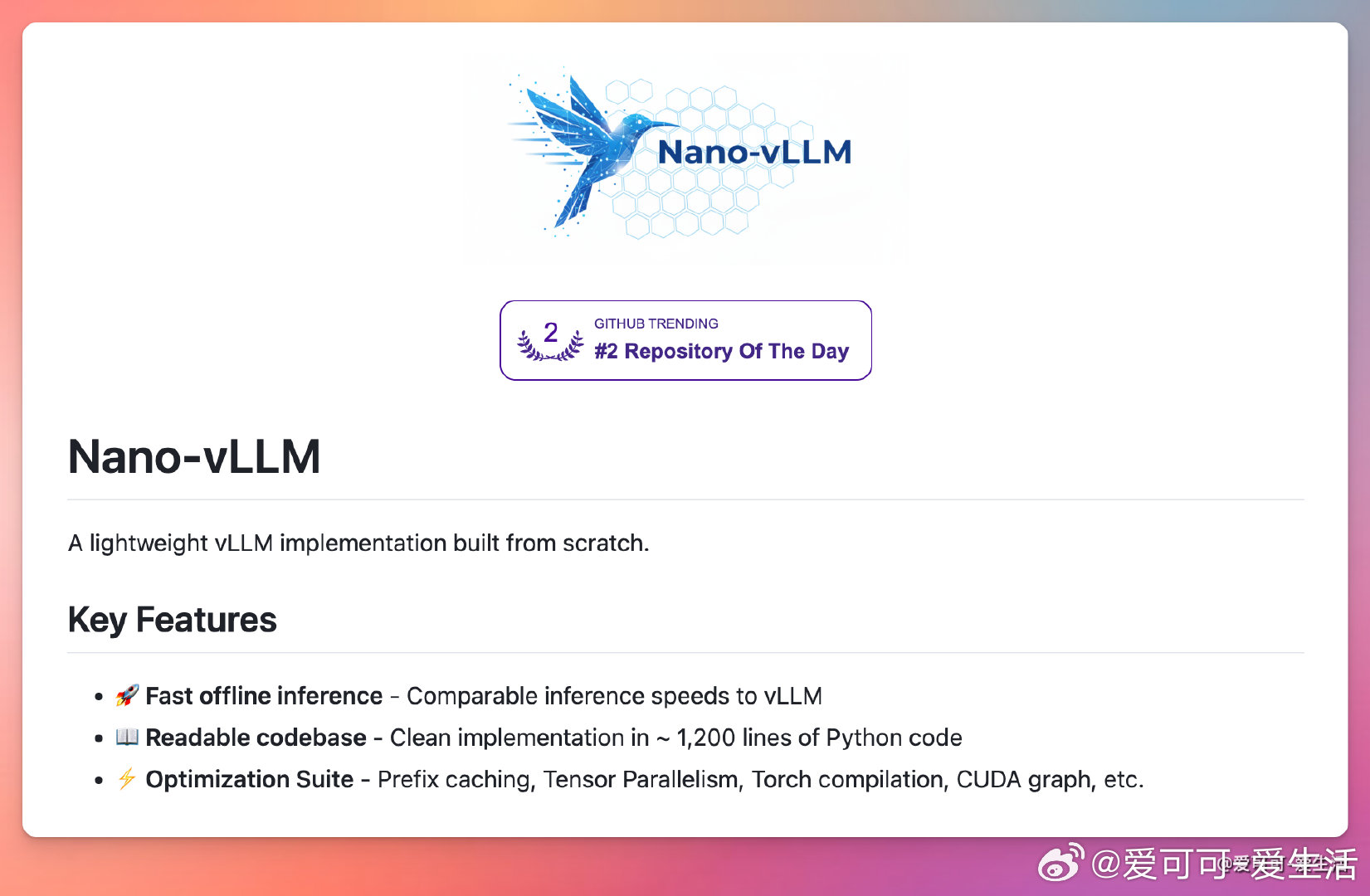

轻量级vLLM实现Nano-vLLM,专注高效离线推理,速度媲美vLLM,代码简洁,仅约1200行Python,便于阅读和二次开发。集成前缀缓存、张量并行、Torch编译、CUDA图优化等多种性能提升技术,支持快速大规模语言模型推理。安装简单,pip一键安装即可启动。支持通过huggingface CLI下载模型权重,API设计兼容vLLM,仅在生成接口上有细微差异,方便无缝切换。适合研究者和开发者使用,RTX 4070等硬件测试下推理效率优异,开源MIT许可,源码托管于GitHub,社区活跃,欢迎试用和贡献。项目地址:github.com/GeeeekExplorer/nano-vllm主要特点:- 高效离线推理,性能稳定且快速- 代码结构清晰,易于理解和扩展- 多种优化技术加速推理过程- 兼容vLLM接口,便于迁移- 支持PyTorch生态,方便集成现有项目适用场景包括NLP模型推理、Transformer大模型加速等,特别适合需要轻量化、高性能推理方案的开发需求。